[밑바닥부터시작하는딥러닝1] Chapter 4. 신경망 학습

[밑바닥부터시작하는딥러닝1] Chapter 4. 신경망 학습

학습 : 훈련 데이터로부터 가중치 매개변수의 최적값을 자동으로 획득하는 것 4.1. 데이터에서 학습한다!✔️ 데이터 주도 학습1. 그림을 분류하는 알고리즘을 사람이 직접 설계2. 이미지에서

heejudeveloper.tistory.com

위 글에서 알아봤던 크로스엔트로피가 확실하게 정의되지 않은 것 같아서 간단하게 한번 더 정리해보려 한다.

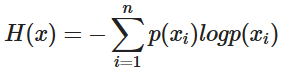

📌 Entropy

불확실성의 척도

엔트로피가 높다는 것은 정보가 많고 확률이 낮다는 것(분류가 잘 되어있지 않다는 것)

📌 Cross-Entropy

실제 분포 q를 모를 때 q분포를 예측하는 것

쉽게 말해 모델이 예측한 확률값과 실제값을 비교했을 때 틀리는 정도를 표현했다고 할 수 있다.

분류문제에서 데이터의 라벨은 one-hot encoding으로 표현한다.

특정 데이터가 n번째 클래스에 속할 때 해당 원소만 1이고 나머지는 0으로 채운 n차원 벡터로 놓는다.

입력데이터가 모델을 통과하면 소프트맥스 함수에 의해 각 클래스에 속할 확률이 구해지고

데이터가 실제로 2번 클래스에 속할 경우 실제 확률 분포는 아래와 같다.

이를 cross-entropy로 표현하면 아래와 같아지며 이를 최소화하는 것이 모델의 목표라고 할 수 있다.

참고 :

https://velog.io/@osk3441/%EC%A0%95%EB%B3%B4%EC%9D%B4%EB%A1%A0Cross-Entropy-Loss-oqshp2jj

'Deep Learning' 카테고리의 다른 글

| Discriminative Learning, Generative Learning이란? (0) | 2024.12.16 |

|---|---|

| L1 Norm, L2 Norm / L1 Loss, L2 Loss 이란? (0) | 2024.12.11 |

| [밑바닥부터시작하는딥러닝2] Chapter 8. 어텐션 (0) | 2024.04.23 |

| [밑바닥부터시작하는딥러닝2] Chapter 7. RNN을 사용한 문장 생성 (0) | 2024.04.22 |

| [밑바닥부터시작하는딥러닝2] Chapter 6. 게이트가 추가된 RNN (0) | 2024.04.21 |