Confusion Matrix

| Positive | Negative | |

| Positive | TP (True Positive) |

FP (False Positive) |

| Negative | FN (False Negative) |

TN (True Negative) |

- TP(True Positive): 실제 Positive를 Positive로 예측

- FP(False Positive): 실제 Negative를 Positive로 예측

- FN(False Negative): 실제 Positive를 Negative로 예측

- TN(True Negative): 실제 Negative를 Negative로 예측

Matrix

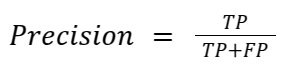

Precision: Positive라고 예측했을 때 실제 Positive 비율

Recall(=Sensitivity=TPR): 실제 Positive 중에 Positive로 예측한 비율

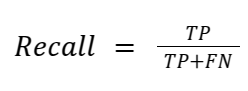

F1-Score: Precision과 Recall의 균형을 고려한 지표

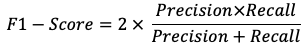

PR(Precision-Recall) Curve: x축 recall, y축 precision으로 우측상단에 가까울수록 성능이 좋다.

AUPR(Area Under PR): PR Curve의 아래 면적으로, 1에 가까울수록 모델 성능이 좋다.

AUPR이 높을수록 모델이 Positive를 잘 예측하고 있다는 의미로 해석 가능하다.

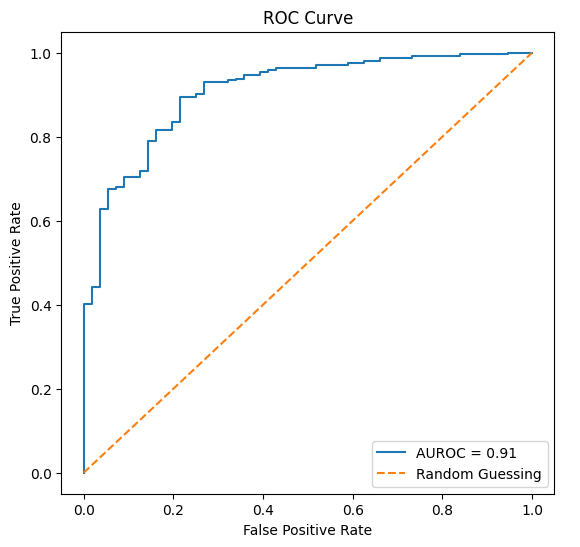

FPR: 실제 Negative 중 Positive로 잘못 예측한 비율

ROC Curve: x축 FPR, y축 TPR로 좌측 상단에 가까울수록 성능이 좋다.

AUROC(Area Under ROC): ROC Curve의 아래 면적으로, 1에 가까울수록 모델 성능이 좋다.

불균형한 데이터셋에 유용하며, 모델의 전체적인 분류성능을 평가할 수 있다.

https://xogns7652.tistory.com/entry/Precision-Recall-TPR-FPR-AUROC-AUPR

'Deep Learning' 카테고리의 다른 글

| AE(Auto Encoder), VAE(Variational Auto Encoder)이란? (0) | 2024.12.22 |

|---|---|

| 베이지안 이론(Bayesian Theroy)이란? (0) | 2024.12.18 |

| Discriminative Learning, Generative Learning이란? (0) | 2024.12.16 |

| L1 Norm, L2 Norm / L1 Loss, L2 Loss 이란? (0) | 2024.12.11 |

| Entropy, Cross entropy loss란? (0) | 2024.04.28 |